Evaluation UX, par où commencer ?

La phase d'évaluation UX design est incontournable même si l'expérience utilisateur est difficile à mesurer.

Comment mesurer l'expérience utilisateur ? Comment vous y prendre pour évaluer l'UX design ?

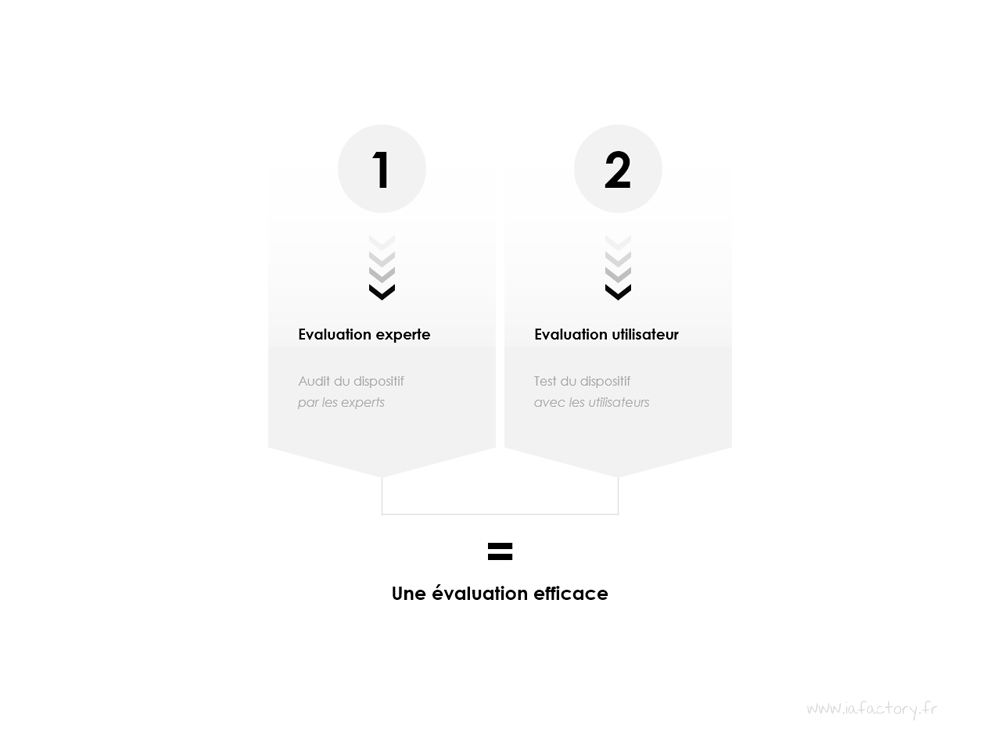

Nous allons voir qu'il y a 2 méthodes complémentaires pour évaluer l'UX dans votre projet.

Par où commencer les évaluations UX design ?

Il y a deux volets pour évaluer l'expérience utilisateur

Dans cet article, nous allons clarifier les moyens à notre disposition pour mesurer et évaluer l'expérience utilisateur. Les différentes techniques d'évaluation de l'expérience utilisateur que nous allons évoquer sont regroupées au sein de la section techniques d'évaluation UX. Il y a finalement assez peu de techniques efficaces, et il n'est pas si compliqué de les mettre en oeuvre dans un projet digital.

Alors, par où commencer pour évaluer l'UX ?

L'évaluation de l'expérience utilisateur est la 3ème et dernière étape du cycle projet dans la méthode UX design. Pour évaluer les solutions de conception, on consacre généralement 10% à 15% du temps projet. Ce n'est pas forcément très long et on apprend toujours quelque chose. Evaluer l'interface utilisateur et le projet digital au sens large permet d'identifier les principaux freins à l'utilisation... Et on ne peut pas vraiment améliorer ce qu'on ne connait pas, n'est-ce pas ?

Pour évaluer l'expérience utilisateur d'un dispositif digital (évaluer l'UX), il est de bon usage de recourir à deux méthodes d'évaluation complémentaires :

- 1. les méthodes expertes : évaluation via le regard technique du professionnel des interfaces - ergonome, architecte de l'information, ux designer.

- 2. les méthodes participatives : jugement sans concession de l'utilisateur final.

Chacune des deux méthodes a ses avantages et ses inconvénients, il est donc tout indiqué de faire cohabiter les différentes approches dans le cadre de l'évaluation de la "qualité de l'expérience" (notion alambiquée, toute relative et fort complexe à éclaircir quantitativement) d'un dispositif digital, afin d'identifier les freins à l'utilisation, les axes d'optimisation et bien sûr le "niveau de satisfaction" côté utilisateur.

1. Evaluer l'UX, méthodes expertes

Lorsque le dispositif digital existe, il s'agit de soumettre le support à la sagacité du spécialiste de la conception pour évaluer l'ergonomie, l'architecture de l'information, le design d'information, le design d'interaction, et plus généralement la qualité de l'expérience de consultation et d'utilisation.

Les objectifs poursuivis par ce type d'évaluation UX consistent clairement à faire émerger les freins à l'utilisation, mais aussi à identifier les points positifs sur lesquels vous pouvez vous appuyer pour améliorer l'expérience. En fonction du profil de l'évaluateur, lequel peut également être polyvalent et complet, l'évaluation de l'expérience portera plus précisément sur tel ou tel aspect du dispositif (ergonomie, architecture de l'information, design de l'information...).

L'intervention la plus courante consiste à évaluer l'ergonomie du dispositif digital au travers de l'audit ergonomique ou plus globalement de l'audit de site web : une grille de critères va permettre de déterminer les principaux freins à l'utilisation mais aussi les éléments particulièrement bien implémentés sur les plans du guidage, de la charge de travail, de l'adaptabilité de l'interface, de la prise en compte du contexte d'utilisation et de l'expérience de l'utilisateur, de la capacité du système à aider l'utilisateur à prévenir / éviter les erreurs... Viennent ensuite des considérations importantes sur le plan de la cohérence, de l'homogénéité et de la signification des codes, bref, autant d'éléments qui viendront étoffer les observations et les analyses.

L'audit ergonomique permettra de détecter 60 à 80 % des principaux freins à l'utilisation, en fonction de la méthode utilisée (un évaluateur vs. plusieurs évaluateur, une partie du site vs. tout le site). Pour accéder à une vision analytique d'ensemble, l'audit ergonomique doit être étoffé de réflexions sur le design de l'information (interface et design d'un écran), le design d'interaction (parcours et enchainements entre les écrans), et également sur l'architecture de l'information et le design de navigation (organisation des contenus et accès). C'est principalement pour cette raison que dans cet article nous préférons utiliser le terme "audit de site web" qui englobe la notion d'audit ergonomique dont les rapports sont parfois rébarbatifs et techniquement incomplet sur le plan de l'expérience...

Par extension, cela revient soit à étoffer l'audit ergonomique au-delà de la seule visée ergonomique, soit à travailler de façon plus approfondie une discipline rattachée au champ de l'UX design au sein d'une approche dédiée. Ce sera le cas, par exemple, avec l'audit éditorial qui vise à mener des analyses approfondies sur la stratégie éditoriale et l'architecture de l'information. L'analyse des contenus est complémentaire de l'audit ergonomique en vue de l'amélioration d'un dispositif digital.

L'audit des indicateurs de fréquentation au travers de l'analyse des performances web (webanalytics) donnera un éclairage complémentaire aux observations formulées sur les plans de l'ergonomie, de l'architecture de l'information et du design d'information / design d'interaction.

On se situe bien dans l'évaluation de l'expérience utilisateur, mais le prisme d'analyse est technique. Avec l'analyse des indicateurs de fréquentation, on bascule dans l'univers de l'analyse de datas avec une focale portée sur les aspects quantitatifs. On raisonne en pourcentage, en volume, pour être capable de déterminer les parties du site visitées vs. abandonnées par les utilisateurs, les pics de fréquentation, les stratégies d'utilisation.

Les données quantitatives sont riches d'informations et permettent de découvrir l'utilisation "réelle" (sur le plan des données) d'un dispositif digital : elles disent "ce qui se passe" mais n'expliquent pas "pourquoi cela se passe". Pour répondre au pourquoi, il faut, d'une part, coupler l'analyse "webanalytics" à des considérations d'ordre ergonomiques, architecturales (etc.), et d'autre part, il faut rentrer dans le cerveau humain et faire appel aux méthodes participatives (techniques dites qualitatives).

Pour résumer, évaluer l'expérience utilisateur et sa qualité (excellente, agréable, juste moyenne, passable, médiocre ?) passe par la combinaison et le croisement de plusieurs sources d'étude conduites par des spécialistes de la conception et de l'analyse, afin d'accéder à une vision d'ensemble, holistique et transdisciplinaire...

Si vous deviez, par exemple, faire appel à iafactory pour analyser un dispositif digital, c'est tout cet arsenal analytique croisé que nous serions amenés à mettre en oeuvre pour éclairer les données quantitatives par des analyses qualitatives. C'est une approche de concepteur. D'analyste. Pour le reste, il n'est pas recommandé d'être juge et parti, c'est pourquoi il est préférable d'avoir des interlocuteurs différents pour la conception et pour l'évaluation. Certes, cela ajoute du monde au portillon du projet, mais ce n'est pas sain d'être à la fois juge et parti. L'histoire de l'être humain reste là pour nous le rappeler... Alors méfiez vous des agences qui réalisent à la fois la conception et l'évaluation !

Voilà pour ce qui concerne les évaluations expertes de l'expérience utilisateur. C'est un volet très important en matière d'évaluation de l'UX design, mais vous ne pouvez pas vous en contenter car les utilisateurs n'ont pas été sollicités à ce stade. Notez qu'un concepteur expérimenté - disons un UX designer confirmé - devrait être en mesure d'identifier beaucoup de freins à l'utilisation par sa connaissance des interfaces et des règles d'ergonomie.

2. Evaluation UX design, méthodes participatives

Les méthodes participatives ne sont pas réservées à Ségolène Royale.

:-).

Pour évaluer l'UX d'un dispositif digital, les données quantitatives ont leurs limites et les indicateurs de fréquentation ne peuvent expliquer à eux seuls les origines de tel ou tel choix. D'autre part, une action réalisée n'implique pas qu'elle ait été pleinement comprise, de même que les analyses de l'ergonome et de l'architecte de l'information peuvent être incomplètes tant les stratégies d'utilisation (et les stratégies de contournement !) d'un dispositif digital sont variées :).

Vous l'avez donc compris, il est important de réintroduire le facteur humain dans toutes ces analyses pour rentrer dans nos têtes d'humains et d'utilisateurs (dimension psychologique et psychosociologique) afin de compléter les méthodes d'évaluation expertes de l'expérience utilisateur. Les méthodes d'évaluation participative de l'UX visent à faire participer une à plusieurs personnes représentatives des cibles du dispositif digital (on observera les personnes interagir avec l'objet digital en groupe ou seule - de préférence).

La méthode la plus courante et la plus intéressante n'est autre que le célèbre test utilisateur dans lequel une personne est amenée à interagir avec le dispositif dans des conditions aux plus proches du réel, bien que "le seul équivalent du réel soit le réel lui-même", comme disent les intellectuels.

En bref, cela permet d'observer les stratégies d'utilisation et les éventuels freins à l'utilisation par rapport à des tâches précises à réaliser : parce que, eh oui, on "teste des tâches bien précises", c'est à dires des actions, des parcours, des enchainements. Il faudra donc se concentrer sur les objectifs prioritaires du site afin que le test utilisateur délivre des informations susceptibles d'améliorer le coeur du dispositif digital. Dans ce travail avec l'utilisateur, l'animateur cherchera à faire verbaliser l'utilisateur pour comprendre ses choix et ses hésitations. Un bon test utilisateur nécessite un minutieux travail de préparation pour déterminer les éléments les plus intéressants à tester : c'est le rôle de l'évaluateur de déterminer les bons ou le bon scenario de test utilisateur.

Qui a dit que c'était simple d'évaluer un dispositif digital ?

Oui... il est possible que nous nous soyons déjà risqués à ce genre de propos sur ce site... Hérésie ! Si on considère l'énormité potentielle d'un dispositif digital et la multitude de parcours, il apparaît clair que l'évaluation de l'UX design et la mesure de l'expérience utilisateur soient pour le moins délicates...

Lorsque le test utilisateur se concentre plutôt sur la capacité du dispositif à répondre de façon, efficace, efficiente et satisfaisante à une tâche précise, le test dit de tri de cartes va quant à lui davantage se concentrer sur les problématiques de perception et de compréhension de l'organisation des contenus. Il s'agira notamment d'évaluer l'adéquation et la résonnance des choix opérés en matière de segmentation, d'arborescence et de navigation, entre la logique des concepteurs et celle des utilisateurs.

Le tri par cartes est un excellent complément au test utilisateur : il permet d'améliorer / d'optimiser les groupements de contenus et les étiquettes de navigation lorsque le test utilisateur permettra de se concentrer sur la bonne adéquation des solutions d'interfaces face aux stratégies d'utilisation effectives...

Nous pourrions aussi parler d'autres modalités d'évaluation directe comme l'eye tracking ou d'autres plus indirectes comme les tests en groupe et les focus groupe. Néanmoins, pour avoir beaucoup pratiqué les différentes techniques, on vous conseillerait plutôt de vous concentrer sur les techniques listées ci-dessus (audit de site web avec un expert, test utilisateurs avec les usagers).

Evaluation en situation d'utilisation

Un mot sur l'évaluation en situation d'utilisation...

Evaluer l'expérience utilisateur doit idéalement se faire "en situation". Juste un exemple : si vous testez une interface tactile embarquée dans une voiture, dans un jolie salle de studio avec vitre teintée pour observer les utilisateurs, vous avez tout faux. De même, si vous invitez les utilisateurs dans un canapé face à un bel écran d'ordinateur, et que vous devez tester une application dont l'usage se fait en gare, là aussi, c'est tout faux.

La situation d'utilisation compte autant que la cible : les bonnes personnes (panel d'utilisateurs représentatif de la cible), qui testent dans des conditions proches de celles ciblées par le produit digital.

C'est évident, certes, mais il fallait tout de même le préciser. Cependant, parfois, vous n'avez ni le temps ni les moyens pour évaluer le dispositif digital dans les conditions idéales. Reste alors l'évaluation sauvage...

Evaluation sauvage

Dans beaucoup de cas, les porteurs de projets, les agences, les commanditaires ont tendance à négliger l'évaluation de l'expérience utilisateur. Cela prend un peu de temps et coûte aussi quelques deniers. Et cela pourrait éventuellement remettre en cause toute ou partie de la production du projet. C'est paradoxal mais c'est un fait : alors que le but de l'évaluation est d'améliorer le projet, la mesure de l'expérience utilisateur peut obliger un retour en arrière dans le processus de production du dispositif digital (corriger les erreurs identifiés, qui sont parfois lourdes...). Les impacts en matière de planification (décalage) et les conséquences sur la mise en ligne du projet, sont réels. Bien sûr on peut l'anticiper.

Pour un tas de raisons empiriques, économiques, organisationnelles, culturelles, l'évaluation de l'expérience reste le parent pauvre du projet. Pourtant, même une évaluation dite sauvage permet d'éviter les pots cassés. Le principe du test est de recueillir des avis. C'est mieux de le faire avec des cibles potentielles du dispositif. Mais on apprendra toujours quelque chose, même avec un collègue, un proche, etc. Le tout est de sortir du schème "moi je préfère" en restant sur une approche factuelle : "essaye de trouver telle chose", "essaye d'identifier telle information", "où cliquerais tu si tu devais...". Les faits. Toujours les faits. C'est mieux de procéder à une évaluation sauvage, à l'arrache, que de ne rien faire.

Optez pour une approche combinée de l'évaluation UX

C'est bien la combinaison de ces différentes approches (évaluation de l'expérience par un expert + évaluation de l'expérience avec les utilisateurs) qui vous permettra d'obtenir les meilleurs résultats. Ici, par "meilleurs résultats", on entend la façon optimale d'évaluer l'expérience utilisateur, le moyen qui va permettre la mesure et l'évaluation de l'expérience au plus proche des stratégies d'utilisation.

Mixer ces différents travaux pour évaluer l'UX design permet par ailleurs de recueillir du "matériel" quantitatif et qualitatif, et d'expliquer telle statistique par telle observation sur le terrain. Bien entendu, nous ne sommes pas dans le domaine atomique de la science académique, mais au coeur d'une approche pilotée par l'humain et pour l'humain, donc imparfaite, tout comme la notion de "qualité d'expérience". L'analyse croisée et holistique qui fait intervenir expert et utilisateur permet vraiment d'apporter de la valeur dans le projet et d'améliorer sensiblement / voire considérablement l'expérience de l'utilisation.

Quoiqu'il advienne, il est impératif de faire participer un spécialiste de la conception à toutes ces problématiques d'évaluation, car les tests ne permettent pas d'identifier de nouvelles solutions de conception, mais simplement d'évaluer l'efficacité des solutions de conception. Car, quoique la pensée dogmatique de l'UX design le laisse parfois à penser, "L'UTILISATEUR N'EST PAS LE CONCEPTEUR".

Voilà, vous connaissez les grands principes de l'évaluation de l'UX. Dans la méthode UX design, une fois l'évaluation effectuée, on repart sur les analyses, la conception, puis à nouveau l'évaluation. L'amélioration de l'expérience est un cycle qui n'a ni début, ni fin. Tout comme l'expérience que vous proposez à travers votre site. On parle de cycle d'amélioration continue.

Cette expérience passe d'abord et surtout par les contenus, l'occasion de focaliser sur la stratégie éditoriale :

Par où commencer sa stratégie éditoriale ?

techniques d'évaluation UX

projets d'évaluation UX

livres pour l'évaluation UX